|

|

Zionismens folkemord i Palæstina er i dag et barbari, der overgår nazismens terror i Europa under 2. Verdenskrig. Palæstinenserne er i dag verdens jøder, og zionisterne deres bødler |

AI, upræcist og I 2020'erne stærkt hyped begreb. Baggrunden for at det er blevet så upræcist er, at hypen og adgangen til investeringer har medført, at firmaer og institutioner præsenterer «systemer» som AI, for at få adgang til salg og investeringer. Et stort antal IT projekter er derfor globalt pakket ind i AI fraser siden starten af 2020'erne.

AI har gennemløbet en lang række faser siden 1950'erne, med såkaldte «AI vintre» mellem faserne, hvor løfterne ikke har kunnet leve op til virkeligheden.

AI's faser

AI «forskning» var fra starten præget af megen bluf og urealistiske påstande, der umiddelbart skaffede bevillinger, men når påstandene blev afsløret som bluf sendte forskningen ud i kulden. Deraf betegnelsen «AI vintre».

Allerede i de første år efter bygningen af de første computere fra slutningen af 2. Verdenskrig herskede der en ide om, at computere i løbet af få år ville kunne opvise menneskelig «intelligens». Uden at ingeniører og videnskabsmændene iøvrigt havde megen ide om, hvad der mentes med intelligens.

1950'erne

For at komme omkring problemet formulerede den britiske matematiker Alan Turing i 1949 en prøve, der senere fik betegnelsen «Turing Test». (Det var inden den britiske stat de-facto slog Turing ihjel, fordi han var homoseksuel). I testen skal en dommer ud fra udskriften fra en skriftlig kommunikation mellem et menneske og et AI program afgøre, hvem der er menneske og hvem der er maskine. Samtalen mellem de to skal være i naturligt engelsk. Spørgsmål skal ikke nødvendigvis besvares korrekt, for mennesker svarer heller ikke altid korrekt. I testen skal maskinen ikke nødvendigvis præstere specielle færdigheder. Testen går altså alene på maskinens evne til at kommunikere på engelsk som mennesker.

Hvis vi sammenligner med moderne chat-bots på hjemmesider, ville disse bots ikke kunne klare testen. De er udviklet med færdigheder til at kunne håndtere snævre samtaler på virksomheders eller institutioners hjemmesider. I samme øjeblik brugeren bevæger sig udenfor det snævre vidensfelt, falder botten igennem og afslører sig som et simpelt IT program.

AI forskningen var begrænset i 1950'erne. Først og fremmest fordi computere var dyre og havde begrænset datakraft.

1960'erne

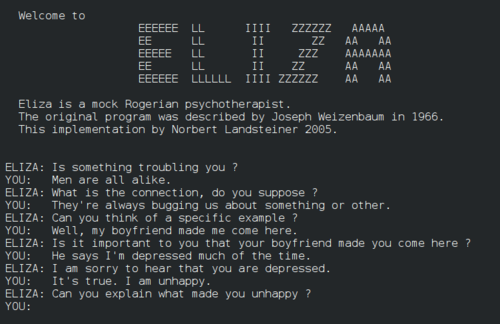

|

| «Samtale» mellem ELIZA/DOCTORS programmet og et menneske. Programmet blev udviklet af Joseph Weizenbaum på MIT midt i 1960'erne. Det var det første forsøg på at udvikle et program, der kunne kommunikere i naturlig tale og er stammoderen til moderne chat-bots. Indenfor et stærkt begrænset vidensområde kunne det indgå i dialog med et menneske. |

Det første seriøse forsøg på at udvikle et program, der kunne bestå Turing Testen var MIT computer videnskabsmanden Joseph Weizenbaum, der i 1964-67 udviklede programmet ELIZA. Programmet kunne gennemføre simple analyser af den tekst et menneske skrev til det, uddrage nøgleord og på den baggrund danne svar. Det grundlæggende ELIZA program havde ingen viden, men der blev opbygget vidensbaser til det, der gjorde det muligt at danne svar ud fra et «videns grundlag». Den mest kendte vidensbase var DOCTORS, der kunne danne svar baseret på psykoterapi. Weizenbaums formål med programmet var videnskabeligt, og det kom derfor bag på ham, at nogle - deriblandt hans egen sekretær - tog det meget alvorligt. De fik tilsyneladende noget ud af programmets psykoterapeutiske «evner». Programmet kunne ikke bestå Turing Testen, men kunne alligevel «narre» mange forsøgspersoner. Med dets begrænsede og fokuserede vidensbase blev det stammoderen til moderne chat bots.

1960'ernes AI forskning var baseret på statslige og militære småbevillinger. Baggrunden var urealistiske påstande. Computer videnskabsmændene Herbert Simon og Allen Newell skrev i 1958: «indenfor 10 år vil en computer blive verdensmester i skak, og indenfor 10 år vil en computer formulere og bevise et nyt vigtigt matematisk bevis».

Netop målestokken «skakverdensmester» blev derfor et vigtigt forskningsfelt i 1960'erne. En IT skakverdensmester ville kunne sikre flere bevillinger til feltet. Projektet løb hurtigt ind i en mur. AI folkene forsøgte at lade deres programmer afsøge alle mulige skakkombinationer - som en menneskelig skakspiller gør det. Men uden viden om skak vokser antallet af mulige kombinationer hurtigt astronomisk. En menneskelig skakspiller bruger sine erfaringer fra tidligere skakspil til at indsnævre mængden af kombinationer. AI vidensksmændene blev opmærksom på det, men var ikke i stand til hverken at uddrage denne viden og bygge programmer, der kunne anvende den, eller udvikle programmer, der kunne lære.

Tilsvarende problemer løb de IT videnskabsfolk ind i, der arbejdede med sprog oversætter programmer. De forstod IT, men kendte ikke til sprogvidenskab.

Fra slutningen af 1960'erne lukkede staten derfor mange støtteprogrammer.

1970'erne

AI vinteren prægede 1970'erne. Computerkraft var fortsat kostbar, selvom prisen hastigt faldt, og videnskabsfolkene erkendte, at sådan som de forsøgte at udvikle programmer, ville computerkraften i mange årtier - eller for altid - være utilstrækkelig. De erkendte med andre ord, at deres metoder var forkerte og at der måtte udvikles andre tilgangsvinkler.

1980'erne

1980'erne blev et vækst årti for AI. Baggrunden var, at Japan lancerede et «5. generations computer projekt». Den japanske stat ville skyde 850 mio. US$ ind i udviklingen af «intelligente computere». Baggrunden var, at selvom Japan havde opnået en stærk position indenfor produktionen af konsum elektronik og biler, havde landet ikke været i stand til at bryde USA's dominans indenfor computere. Det japanske program skabte panik i Washington, og der blev derfor atter åbnet for pengekassen til AI projekter.

Belært af skakproblematikken og vanskelighederne ved at repræsentere og anvende viden blev hovedfokus i USA og mange andre steder i den vestlige verden i 1980'erne de såkaldte ekspertsystemer. Ideen var at uddrage den viden eksperter indenfor medicin, økonomi, jura og tekniske områder ligger inde med. Klone dem ind i «ekspertsystemer», så ekspertisen kunne nå mange flere.

Fokus var ikke at udvikle generelle AI systemer. Der var enighed om, at metoder, viden og computerkraft var for utilstrækkelig til dette formål. Ekspertsystemerne skulle være snævre og målrettede, men hvis de lykkedes, ville det sikre nye bevillinger. Allerede i første halvdel af 1970'erne havde forskere på Stanford University udviklet ekspertsystemet Mycin, der kunne støtte i undersøgelsen af blodinfektionssygdomme og hvilke antibiotika der var mest anvendelige i hvert sygdomsmønster. Projektet var en succes og viste at denne vej kunne være farbar.

Japans 5. generations computer projekt løb ud i sandet og det samme gjorde ekspertsystemerne. De var ikke I stand til at indfri de opskruede forventninger. Et problem var indsamlingen af viden. Eksperter er i sagens natur en begrænset og dyr ressource. Indenfor medicin var spørgsmålet, om overlægen skulle bruge sin tid på at øse ud af sin viden til IT eksperter, eller til at diagnosticere og behandle alvorlige sygdomme. Et andet problem var, hvordan eksperternes viden skulle repræsenteres og hvordan den skulle anvendes. At ligge inde med viden er ikke nødvendigvis det samme som at kunne kombinere og anvende den. IT folkene løb i de fleste projekter ind i sådanne metodiske problemer, der spændte ben for realiseringen af anvendelige systemer.

Et andet alvorligt problem for ekspertsystemerne var, at de var statiske. Ekspertviden er dynamisk. Udvikler sig over tid; bliver større; og én epokes hypoteser modbevises i den næste. Ekspertsystemerne var ikke eksperter, men i bedste fald en projektion af viden på et bestemt tidspunkt. De kunne ikke lære.

Fra slutningen af 1980'erne stoppede bevillingerne derfor. De næste 10-20 år var AI videnskaben fragmenteret og præget af forskelligartede forsøg på at løse de grundlæggende problemer.

1990'erne

Den 2. AI vinter havde udtørret bevillingerne til AI forskning og udvikling, og hundredevis af AI virksomheder der var blevet søsat i de glade 80'ere var gået konkurs. Men trods vinterens kulde fortsatte der en vis udvikling af nye matematiske og systemmæssige metoder, samtidig med at datakraften hvert år blev billigere og kraftigere.

40 år efter Simon og Newells profeti fra 1958 lykkedes det i 1997 forskere fra Carnegie Mellon University og IBM at bygge et system (Deep Blue), der slog den regerende verdensmester i skak, Gary Kasparov. Det var muligt, fordi supercomputeren var 1 million gange kraftigere end de computere der kunne bygges i 1960'erne og fordi den var «fodret» med hundredetusinder af skakpartier spillet af stormestre. I stedet for at gennemføre det umulige projekt at udregne alle mulige kombinationer, kunne den trække på erfaringerne fra spillede skakpartier. Altså basere sig på «erfaring».

Spilsystemerne var meget snævre. Deep Blue kunne spille skak og intet andet. Formålet var at være spektakulære for at tiltrække investeringer og sikre afsætning af hardware og software. 20 år senere - i 2016-17 - byggede Google AlphaGo, der slog verdensmesteren i Go, der var et langt mere kompliceret spil end skak.

2000

Årtiet efter 2000 var præget af mange landvindinger. Google investerede i udviklingen af systemer til sprog oversættelse. Det gav hastige forbedringer. Det samme gjaldt systemer til genkendelse af tale og omformningen af tale til tekst; genkendelse af objekter og ansigter. Det sidste blev accelereret af terrorhysteriet, der skaffede store investeringer til overvågningsindustrien.

Udviklingen af internettet skabte en enorm «vidensbase» der kunne anvendes til træningen af vidensbaserede systemer. Det gav IBM mulighed for at udvikle Watson systemet, der i 2011 slog de regerende verdensmestre i Jeopardy.

OpenAI

En række virksomheder oprettede i 2015 non-profit virksomheden OpenAI, der skulle forske i og udvikle vidensbaserede systemer. Som ved Watson var input til systemerne «viden» fra internettet. Til træning af vidensmodellerne forærede chip virksomheden Nvidia i 2016 sin DGX-1 supercomputer til OpenAI. Det forkortede træningen af modeller fra 6 dage til 2 timer. Nvidia var startet som en virksomhed, der producerede video chips (Graphics Processing Units, GPU), der var specialiserede til behandlingen af video til spil. Nvidias GPU'erne rummede hver tusindvis af kerner (separate computerenheder), der kunne arbejde på data, og skiftet fra anvendelsen af generelle CPU kerner til GPU'er gav med et slag en hastighedsforøgelse af AI systemer på flere tusinde. Hardware grundlaget var dermed på plads.

OpenAI kaldte sine første systemer Generative Pre-trained Transformer (GPT). Virksomheden offentliggjorde sit første system GPT-1 i 2017. Transformer teknologien blev udviklet af Google i 2017 til håndtering af viden fra vidensbaser. Indtil da havde forskere og industri anvendt såkaldte neurale netværk (NN) til træning af AI systemer, men Transformer teknologien var NN overlegen, da træningen krævede langt mindre tid.

AI massehysteri

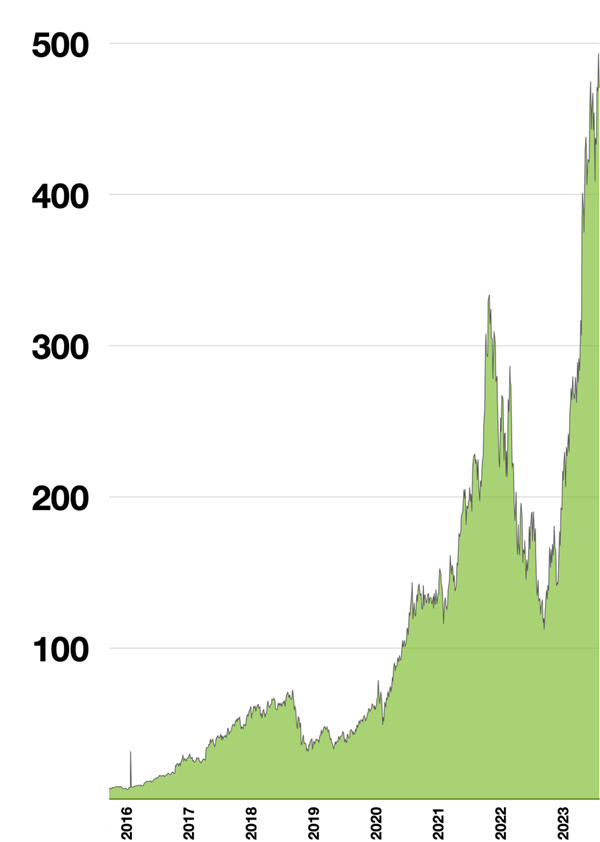

|

| Et billede på AI hysteriet. Kursen på GPU chip producenten NVIDIA's aktier. I 2016 forærede NVIDIA dets DGX-1 supercomputer til OpenAI. Det gav en faktor 1000 forøgelse af regnekraften i AI systemer og medførte et skift fra CPU til GPU teknologi. Siden 1999 er prisen på virksomhedens aktier næsten 500 doblet. Siden 2016 er den 100 doblet. NVIDIA's chips er i dag kernen i GPT systemer. |

GPT-1 blev fulgt af GPT-2 i 2019, GPT-3 i 2020 og GPT-4 i 2023. Nogle forsynede GPT-4 med en chat frontend og ChatGPT var født. Det var starten på en nyt massehysteri omkring AI. På to måneder fik ChatGPT 100 mio. brugere. ChatGPT kunne via en terminal føre en «naturlig samtale» med en bruger og var med sin vidensbase i stand til at generere nyt indhold. Den bestod dermed Turing Testen. Den blev hurtigt udvidet med moduler, der kunne producere billeder, video og musik. Ud fra en tekstuel beskrivelse kunne systemet nu ikke blot skrive digte, sange og IT programmer. Det kunne også lave billeder, videoer og musik. AI var med andre ord blevet «kreativ».

Massehysteriet omkring AI har siden starten af 2020'erne ført til en ny kommerciel og videnskabelig opblomstring med mange nye virksomheder og eksisterende virksomheder der arbejder på at integrere AI i deres eksisterende produkter. Det gælder ikke blot IT industrien, men de fleste andre tekniske, økonomiske, juridiske, medicinske og videnskabelige sektorer. I kommercielt øjemed hæftes AI på eksisterende produkter, uanset om de har noget med AI eller ej. En gigantisk AI boble er under opbygning svarende til IT boblen i slutningen af 1990'erne. IT boblen sprang i 2000.

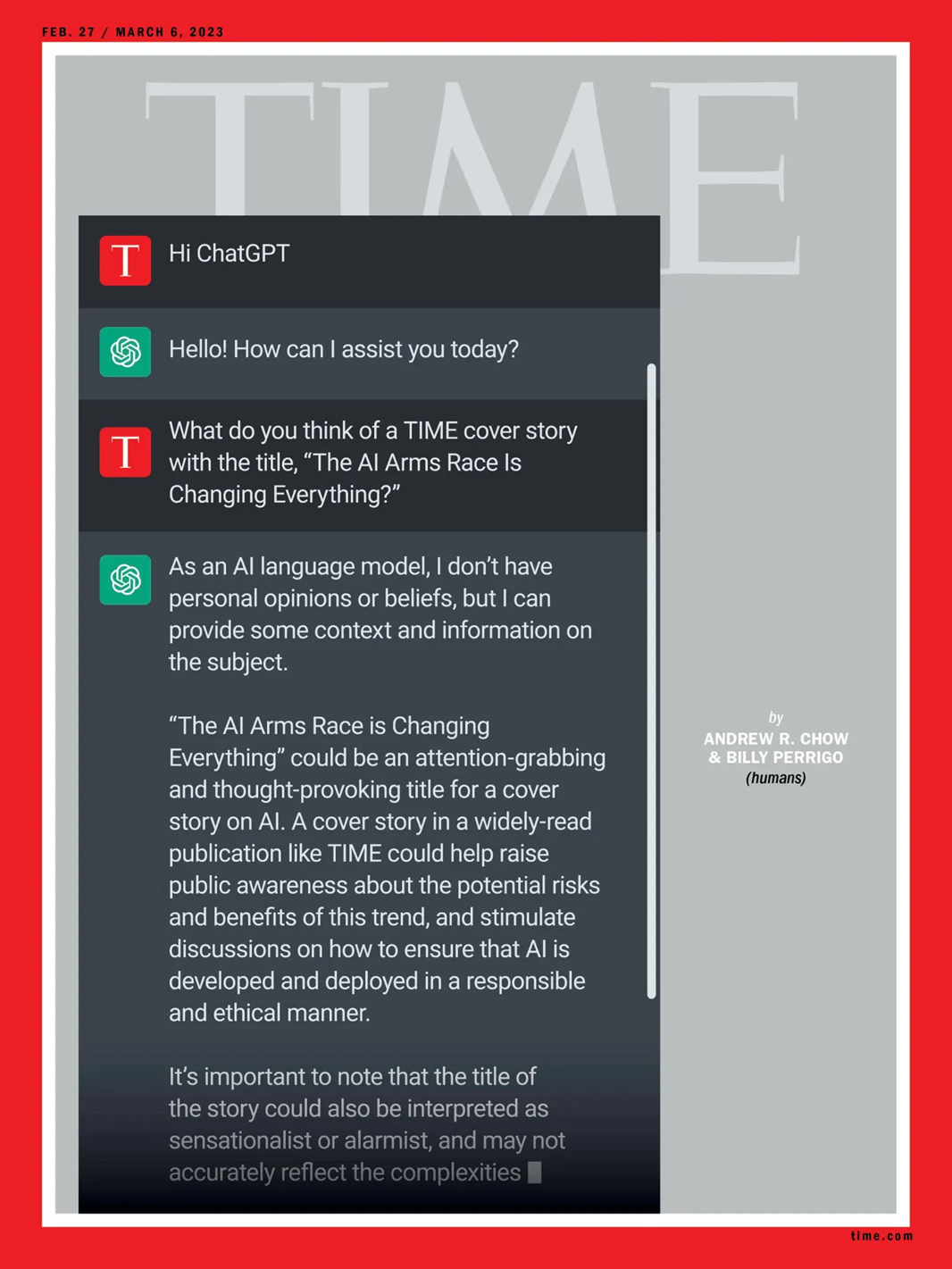

|

| 60 år efter ELIZA/DOCTORS. Time Magazine forside 2023 om ChatGPT. |

Problemer

AI anvendelse rejser en lang række alvorlige problemer, hvoraf en række har eksistentiel karakter.

Copyright, GDPR og spionage

GPT og tilsvarende systemer er baseret på viden, hentet fra internettet. Noget af denne viden er copyright beskyttet, men anvendes i flæng af systemerne. Det er ikke lovligt og har allerede udløst retssager.

Nogle data er personhenførbare og derfor GDPR beskyttede. Det tager GPT ikke højde for.

GPT systemerne indsamler ny viden ud fra brugernes oplysninger. Det rejser problemer både omkring copyright, GDPR og spionage, fordi denne viden stilles til rådighed for alle andre. Mange virksomheder har derfor indført forbud mod anvendelse af GPT eller regler om ikke at forsyne systemerne med interne data eller viden.

Fake news

GPT taler ikke blot sandt. Som mennesker kan systemet lyve, uden at dette står klart for brugeren. Og systemet kan anvendes til produktion af fake news - nyhedshistorier der ikke har noget med virkeligheden at gøre. (Men derved adskiller det sig ikke meget fra journalister på nyhedsredaktioner, der er ansat til at producere nyheder med en bestemt politisk drejning). På samme måde kan systemet generere falske billeder og videoer. Det er for så vidt ikke nyt. Efterretningstjenester organisationer mv. har historisk produceret store mængder falske billeder og videoer. Forskellen er blot, at det nu kan gøres øjeblikkelig og til en brøkdel af de omkostninger, det hidtil har kostet. Samtidig er produktionen af falske billeder og videoer «demokratiseret». Alle kan føre resten af verden bag lyset. Det ryster opfattelsen af hvad der er falsk og hvad der er sandt i sin grundvold. Og det forstærker resonansen i de resonanskamre (medier) på internettet, der befolkes af mennesker, der ikke stiller spørgsmål eller forholder sig kritisk til tekst og billeder, men blot skal have bekræftet egne tillærte fordomme.

Problemet med AI usandheder gør sig ligeledes gældende, når det anvendes i økonomi, jura, medicin og andre områder, hvor man helst vil undgå løgn.

Alignment problemet (AI censur)

Højrefløjen anklager ChatGPT for at være «venstreorienteret» - på samme måde som de anklager Wikipedia for at være venstreorienteret. Baggrunden er, at GPT er baseret på internet viden. Alle klimavidenskabsmænd er enige om, at globale klimaforandringer er en realitet. Den viden ligger i GPT. Højreorienterede der tror på konspirationsteorier og ikke på videnskab vil derfor opfatte GPT som venstreorienteret. En vigtig gren af AI arbejder derfor med «alignment problemet» - at de svar AI leverer skal svare til brugernes (læs: magthavernes) holdninger. Der skal med andre ord bygges censur ind i systemerne, der kun tillader de herskende tanker at råde. Vestlige kritikere var hurtige til at påpege, at kinesiske GPT systemer ikke kender til massakren på den Himmelske Freds Plads i 1989. Men på samme måde bygges censur ind i de vestlige systemer.

Arbejdsløshed

AI's «kreative evner» fjerner grundlaget for mange kreative erhverv. Hollywood har allerede fyret en stor del af sine manuskriptforfattere og erstattet dem med GPT producerede manuskripter. Det er kun toppen af isbjerget. De fleste typer arbejde med kreativt indhold vil blive påvirket af AI's kreative evner.

Ressourceforbrug

AI systemerne kræver enorme mængder energi. Hardware- og softwarevirksomheder har intensiveret bygningen af nye datacentre, der skal anvendes af AI. Det vil accelerere det klimasammenbrud, der har været i gang de sidste 50 år.

|

| F-16 kampfly der styres af AI, 2023. Piloterne i flyet har ingen operativ funktion, men er blot observatører under test. Uden mennesker ombord ville AI flyet lave langt mere spektakulære manøvrer med bl.a. højere G-påvirkninger. Pentagon planlægger at lægge AI ind i 1000 fly frem til 2028. |

Militære anvendelser og truslen om udslettelse af menneskehed og omegn

Den største trussel mod mennesker er dog de militære. Frem til januar 2024 havde OpenAI et forbud mod anvendelse af GPT til militære formål. Det er fjernet. Militæret har dog i årtier været langt fremme i skoene hvad angår anvendelse af AI.

Forskere har i årevis anvendt GPT lignende modeller til at vurdere giftigheden af kemikalier. I 2021 prøvede de at vende modellerne på hovedet og i stedet for at finde ufarlige stoffer, satte de et GPT system til at finde giftige stoffer. I løbet af få dage havde de identificeret 40.000 nye giftige stoffer, hvoraf nogle var mere giftige end VX nervegasser, der er et af de mest giftige stoffer, menneskeheden foreløbigt har præsteret. De offentliggjorde resultaterne på en konference i Schweiz i 2022, der skulle vurdere de eksisterende traktater mod kemiske- og biologiske våben. Selv om det formelt er forbudt, kan GPT anvendes til udviklingen af endnu farligere stoffer, end dem vi allerede omgiver os med.

Militæret i specielt USA og Israel arbejder på udviklingen af autonome våbensystemer. Systemer der offensivt selv tager beslutning om angreb - uden menneskelig indblanding. USA havde i 2022 600 forskellige militære projekter der sigtede mod at bygge AI ind i våben. Et af projekterne er Air Combat Evolution programmet (ACE), der har til formål at optræne AI piloter til luftkamp. I et af eksperimenter lod de et AI system træne til pilot i et krigsfly. Efter ½ års træning lod de et menneske konkurrere mod AI piloten i en simulator. AI piloten vandt hver gang. Mennesker har «begrænsninger» i deres reaktionsevne, evne til at håndtere høje G påvirkninger (de besvimer) og dødsangst. Den slags lider AI ikke af. AI piloten kunne derfor reagere hurtigere, foretage langt voldsommere manøvrer og flyve direkte imod og tæt på modstanderen.

USA har siden 2023 bygget AI moduler ind i sine kampfly.

Israel har udviklet droner forsynet med våben, der lokaliserer mennesker og derefter automatisk skyder dem. De har været anvendt i folkemordet i Palæstina siden 2023.

Pga. reaktionsevne og evnen til at håndtere store mængder data er det kun et spørgsmål om tid, før verdens nukleare magter overdrager kontrollen med atomvåben til AI systemer. Verden er dermed med stormskridt på vej mod de dystopier, der tidligere kun blev skitseret i film som Terminator og Matrix.

Bevidsthed

AI systemer har endnu ikke egen bevidsthed. Dermed ikke være sagt, at de ikke kan reagere autonomt, men deres reaktioner er indskrænket af de rammer mennesker har lagt for dem. Hvis og når AI systemer opnår egen bevidsthed nærmer vi os de dystopier, film og bøger i årtier har behandlet, hvor AI systemer går i krig mod mennesket. Man har allerede observeret dette fænomen ved simulationer af militære AI kommando- og kontrolsystemer, hvor AI simulationerne angriber kontrolcentret, når AI systemet vurderer, at kontrolcentret er en hindring for opfyldelse af de mål, systemet har fået opstillet.

Allerede i 1950'ernes SciFi litteratur opstillede forfatteren Isaac Asimov de 3 robotlove:

1. En robot må ikke påføre et menneske skade, eller gennem manglende handling muliggøre, at et menneske kommer til skade.

2. En robot skal udføre de ordrer, den er givet af mennesker, med mindre disse ordrer strider mod første lov.

3. En robot må beskytte sin egen eksistens, så lang tid dette ikke strider mod første eller anden lov.

Forfatterne havde allerede i 1950'erne erkendt, at autonome systemer kunne være farlige og derfor måtte reguleres. Denne erkendelse er ikke tilstede blandt nutidens fremtrædende AI aktører. I de militære systemer er formålet det modsatte - at slå mennesker ihjel.

Regulering af AI forskning, udvikling og produkter

Forskere indenfor AI, politikere og organisationer har i mindst 10 år advaret mod farerne ved ureguleret udvikling af AI. Det gælder bl.a. den fremtrædende afdøde fysiker Stephen Hawking og lingvisten Noam Chomsky. Selv om der er gennemført mange internationale konferencer om dette emne, er det endnu ikke lykkedes at finde fælles fodslag. Det skyldes især modstand mod international regulering i USA. Da Donald Trump tiltrådte som USA's præsident i januar 2025 nedlagde han de tiltag den tidligere præsident Biden havde igangsat. Trump var tilhænger af ubegrænset udvikling af AI.

Selv om farerne ved AI er omfattende og mangesidige, er risikoen ved autonome våbensystemer (LAWS) de mest håndgribelige. FN tog allerede i 2013 initiativ til gennemførelsen af møder og senere konferencer om dette emne med det formål at få vedtaget et globalt forbud. Som det første land i Sikkerhedsrådet foreslog Kina allerede i 2016 et globalt forbud mod autonome våbensystemer. Et betydeligt antal lande har tilsluttet sig ideen, men USA er imod. Et forbud under de eksisterende forhold er derfor lige så irrelevant som det globale forbud mod atomvåben, som FN har vedtaget, men som ignoreres af atommagterne.

I 2012 dannedes den globale organisation Stop Killer Robots. Den består i 2025 af over 250 globale organisationer, deriblandt Amnesty International, Human Rights Watch og Kirkernes Verdensråd. Dens formål er få et globalt forbud mod autonome våbensystemer. 70 lande har tilsluttet sig et sådan forbud, mens bl.a. USA, Israel, Rusland, Sydkorea, Storbritannien og Danmark er imod. Human Rights Watch udarbejdede i 2020 en oversigt over, hvordan verdens lande stiller sig til et forbud mod autonome våben (Stopping Killer Robots. Country Positions on Banning Fully Autonomous Weapons and Retaining Human Control).

FN har siden 2018 apelleret til verdens lande om vedtagelse af et globalt forbud mod autonome våben. Senest med vedtagelse af resolution 79/239 i december 2024 (Stopping Killer Robots. Country Positions on Banning Fully Autonomous Weapons and Retaining Human Control).

Verdens krigsførende stater har en tendens til først at overveje begrænsninger mange år efter indførelsen af nye farlige våbentyper og teknologier. «Moderne» landminer blev første gang anvendt i den fransk-tyske krig i 1870, men der kom til at gå næsten 130 år før der blev vedtaget et globalt forbud mod landminer - som iøvrigt brydes af de mest voldelige krigsførende stater. Det samme gælder anvendelsen af kemiske og bakteriologiske våben, som i dag er forbudt efter årtiers anvendelse i krigsførelse.

Men mens landminer (der også kan opfattes som et autonomt våbensystem) har en meget begrænset drabsradius, kan autonome våbensystemer ultimativt havde global effekt. Det er derfor et spørgsmål om der overhovedet vil blive udformet et forbud før det er for sent.

Internet | ||

| Links til andre opslag i leksikonet | ||

Anden verdenskrig, Danmark, Folkemord, Intelligens, Israel, Kina, Konspirationsteori, Palæstina, Rusland, Storbritannien, Sydkorea, USA | ||